multipleheadbreaker结构原理

图解Transformer之三:深入理解MultiHead

2023年11月24日 — 多头注意力机制 在Transformer中,注意力模块会并行地重复计算多次。 其中的每一次计算被称为一个注意力头(Attention Head)。 注意力模块将其Query、Key和Value参数分成N份,然后将每一份独立 2024年4月29日 — 随着Transformer模型的迅速普及,SelfAttention(自注意力机制)和MultiHead Attention(多头注意力机制)成为了自然语言处理(NLP)领域中的核心组件。本 深度探索:机器学习中的多头注意力机制(MultiHead 2020年2月29日 — 在「拆 Transformer 系列一:EncoderDecoder 模型架构详解」中有简单介绍 Attention,SelfAttention 以及 MultiHead Attention,都只是在直观上介绍 Attention 的作用,如何能够像人的视觉注意力机制那 拆 Transformer 系列二:Multi Head Attention 机 2023年9月25日 — 多头注意力(MultiHead Attention)机制是自注意力(SelfAttention)的一个扩展,主要出现在自然语言处理(NLP)和其他序列模型中。 它的起源可以追溯 一步步手撸Transformer之(二)—— Multihead Attention

.jpg)

transformer中multihead attention到底到底是如何计算的?

2021年5月30日 — 可能有放大的时机问题、有奔跑方向的问题、有己方支援方式问题、有对方同伴是否干扰问题、有预判了对方心态问题等等,诸多问题都同时考虑。这就是 Multi 2024年3月8日 — 本文将详细解析 Transformer 模型中的 MultiHead Attention 机制,通过简明扼要、清晰易懂的语言,让读者理解这一复杂技术概念。 我们将通过源码、图表、实例 深入拆解 Transformer:MultiHead Attention 机制详解2021年11月27日 — 关联式容器 C++STL包含了序列式容器和关联式容器: 序列式容器里面存储的是元素本身,其底层为线性序列的数据结构。比如:vector,list,deque,forwardlist(C++11)等。关联式容器里面存储的是结构的键值对,在数据检索时比序列式 STL详解(十)—— set、map、multiset、multimap的介绍 2024年3月25日 — 专注探讨UUID的核心原理及其生成机制,并详细介绍不同版本UUID(如版本1的时间戳+节点ID、版本4的随机数生成等)背后的数学原理和技术细节。 uuid 深度解读UUID:结构、原理以及生成机制深度解读UUID:结构、原理以及生成机制 CSDN博客

一文搞懂MOSFET结构、符号、工作原理(一)

2024年1月13日 — 文章浏览阅读23w次,点赞84次,收藏211次。一文搞懂MOSFET结构、符号、工作原理mosfet电路符号 文章目录0 什么是三极管1 双极性晶体管(BJT)2 场效应晶体管(FET)21结型场效应 2019年2月10日 — 到2018年,在LC500H车型上,雷克萨斯将其两级混动系统进一步升级为多级混动系统(MultiStage Hybrid System),就是带四级减速器的ECVT L310 。下表为雷克萨斯的混动系统进化过程的代表车型: L110/L110F结构与原理 L110为两级速混动变速 雷克萨斯多级混动系统(L110L310) 知乎专栏2023年11月24日 — 在前几篇文章中,我们已经了解了什么是Transformer,它的架构以及它的工作原理。 在本文中,我们将更进一步深入探讨多头注意力(Multihead Attention),这也是Transformer的核心。 Transformer中注意力机制的使图解Transformer之三:深入理解MultiHead Attention 知乎2023年7月4日 — 将ARM处理器作为NoC系统中的一个资源节点,设计了资源网路接口,基于Linux操作系统的基础上,编写了FPGA设备的驱动程序。在典型的3×3 2D Mesh结构的NoC系统中进行了测试,结果表明该设计实现了ARM处理器资源节点和NoC系统中其他IP核数据的高速、可靠传输。基于NoC的多处理器系统; NoC的基本结构和原理;Router

.jpg)

Transformer系列:MultiHead Attention网络结构和代码解析

2024年7月9日 — MultiHead Attention网络结构解析 Transformer采用多头注意力机制,模型网络结构如下 MultiHead Attention 其中h表示头的个数,每个头都包含单独的一个缩放点积注意力以及注意力前的线性映射层,多个头的结果concat,输入到最后的全连接映射层,缩放点积2020年2月3日 — 一、multimap的相关原理 multimap与map一样,都是使用红黑树对记录型的元素数据按元素键值的比较关系,进行快速的插入、删除和检索操作,所不同的是multimap允许将具有重复键值的元素插入容器。在multimap容器中,元素的键值与元素的映照数据的 multimap的相关原理——(映照容器)2023年11月27日 — 文章浏览阅读940次。本文介绍了MultiLoRA,通过改善LoRA奇异值分解不均匀的问题,提高LoRA在多任务领域的性能表现。本文通过多个LoRA连加并且引入可训练的系数因子改变LoRA中B矩阵的初始化方式提高性能表现。通过多个空间特征的热力图 【论文阅读笔记】MultiLoRA: Democratizing LoRA For 2024年2月2日 — 本节首先以典型低压熔断器为例,介绍常见熔断器的基本结构,进而细致介绍、分析其主要工作原理和过程,为后续应用设计打下基础。 熔断器的外观结构有圆柱形、长方形、扁平形、楔形等多种形式,以适用于不同设备和场合,见图1,但其内部结构是基本 一文读懂:熔断器的基本结构、工作原理及物理过程 知乎

.jpg)

深入解析Transformer中的多头自注意力机制:原理与实现

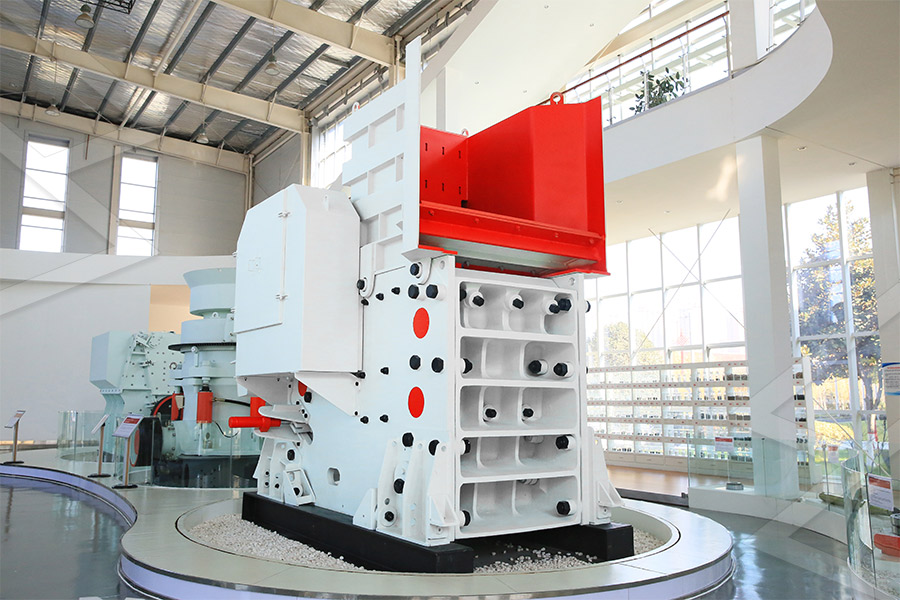

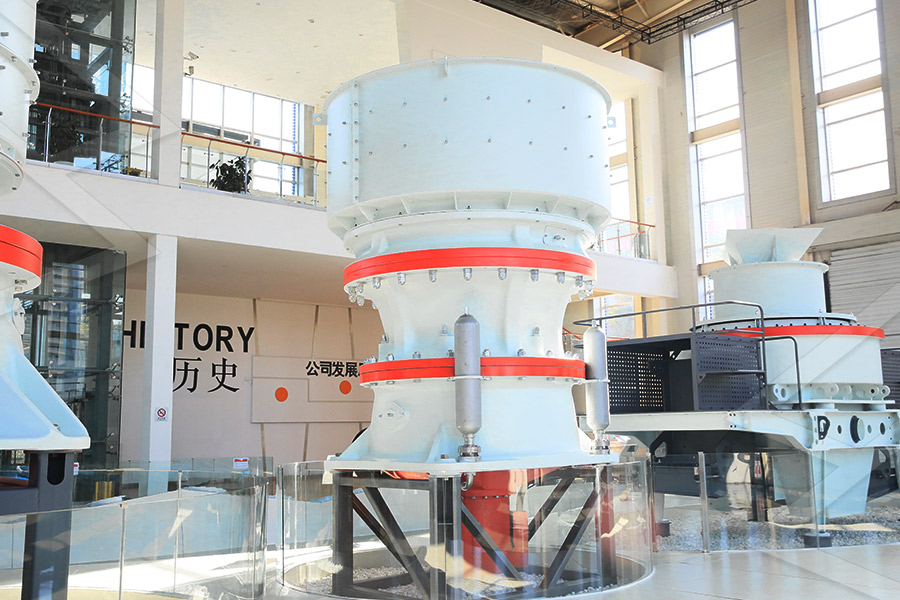

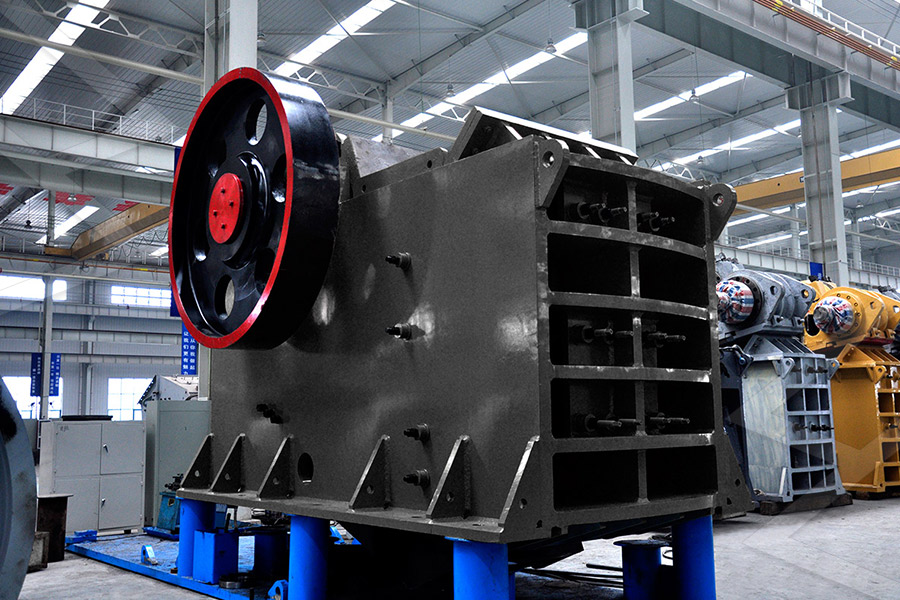

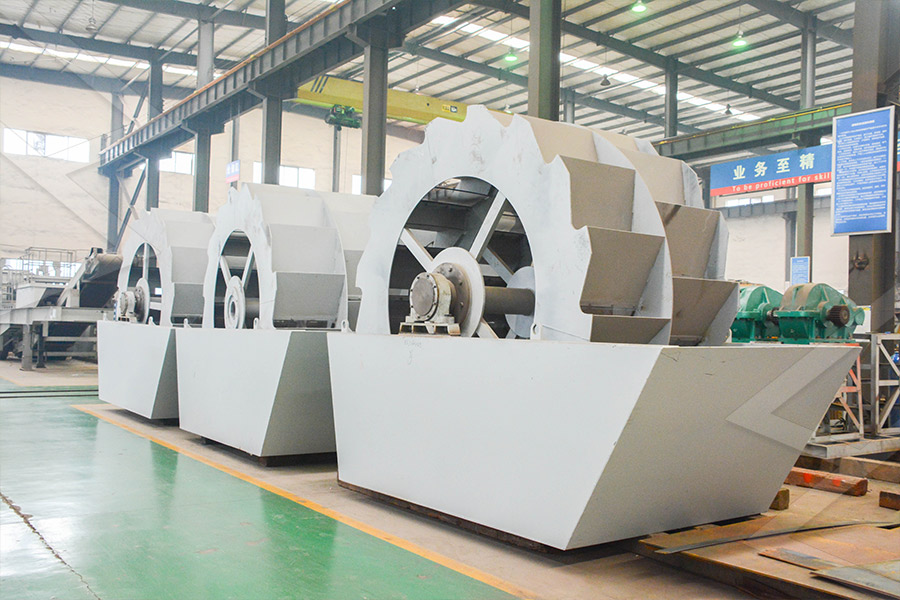

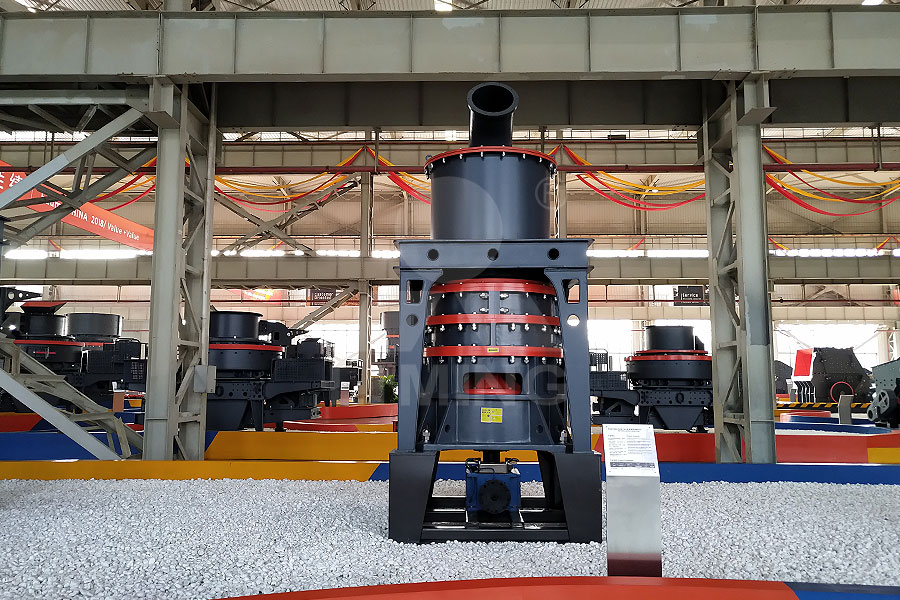

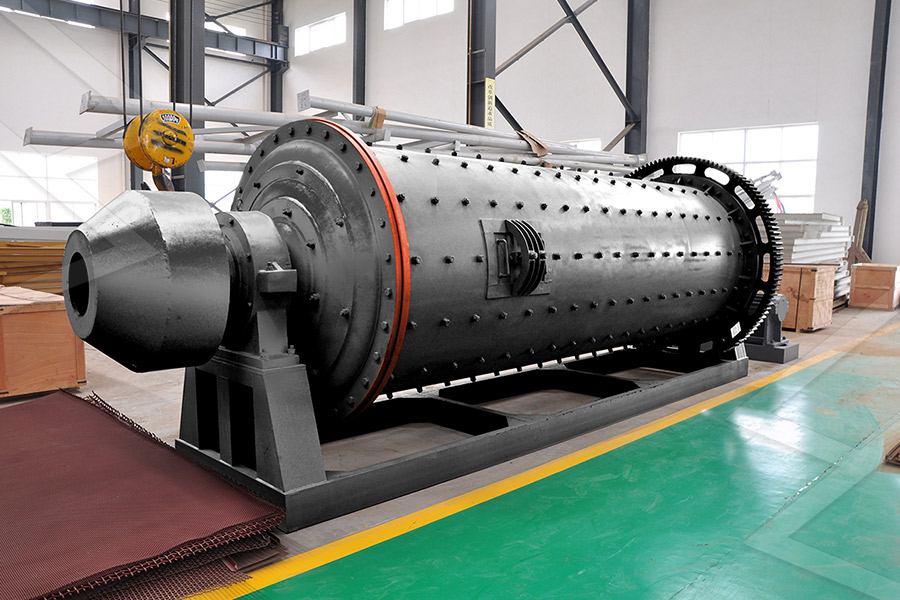

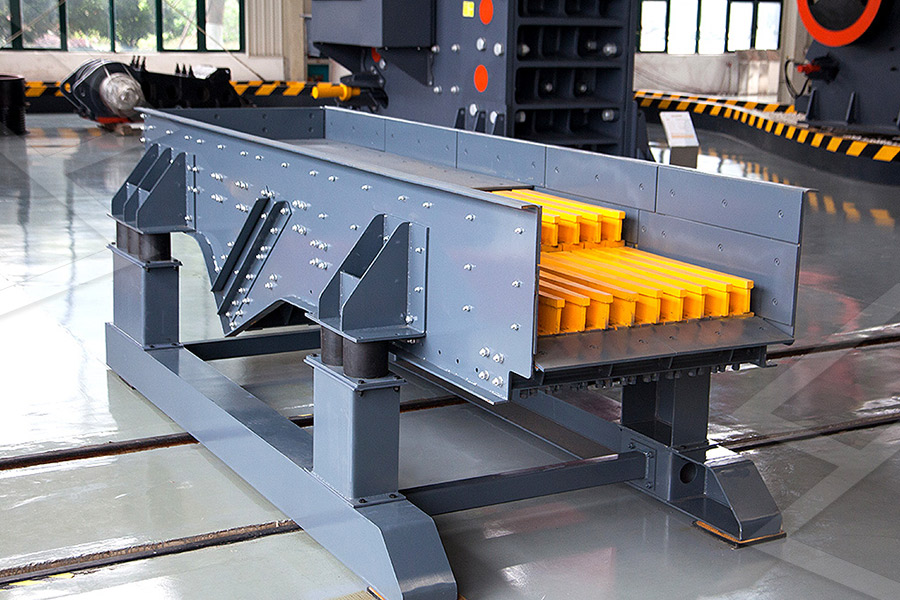

2024年8月29日 — 这是关于Transformer系列文章的第三篇部分,我们将用自上而下的方式深入探讨Transformer的功能。在前两篇文章中,我们已经了解了Transformer是什么、它的架构以及工作原理。没看过的同学可以点击图片进行查看本文将更进一步,深入剖析Transformer的核心——多头注意力(Multihead Attention)机制。2022年3月18日 — 文章浏览阅读18w次,点赞29次,收藏106次。引言CDMA(Code Division Multiple Access)即码分多址,是一种信道复用技术,它允许每个用户在同一时刻同一信道上使用同一频带进行通信 计算机网络CDMA工作原理分析与例证说明 CSDN 2023年2月21日 — 文章浏览阅读66k次,点赞17次,收藏31次。MultiHead Attention 是由多个 SelfAttention 组合形成的。multihead attention代码 MultiHead Attention的讲解 一、什么是 Attention Attention机制最早是在 【深度学习】MultiHead Attention 原理与代码实 硕士论文多锤头破碎机碎石化机理研究与工作装置的运动仿真 2012年10月27日 锤头 破碎机 工作装置 碎石 仿真 路面 本论文结合MHB碎石化设备的引进,以该设备在国外的基本应用情况为基础,对国内应用标准、工艺、施工质量控制等方MHB(MultipleHeabBreaker)多锤头破碎机

.jpg)

一文带你掌(放)握(弃)ViT(Vision Transformer)(原理

2021年7月1日 — 图1 ViT算法结构示意图 图像分块嵌入 考虑到在Transformer结构中,输入是一个二维的矩阵,矩阵的形状可以表示为 (N,D) ,其中 N 是sequence的长度,而 D 是sequence中每个向量的维度。 因此,在ViT算法中,首先需要设法将 H * W * C 的三维图像转化为 (N,D) 的二维输入。2023年7月11日 — 多头自注意力机制(MHSA)的工作原理 与应用 引言 自然语言处理领域的研究经历了多年的发展,而多头自注意力机制(MultiHead SelfAttention, MHSA)作为一种关键的技术,广泛应用于各种任务中,如机器翻译、文本生成和情感分析等。本文将介 多头自注意力机制(MHSA)的工作原理与应用CSDN博客2024年7月24日 — 自然语言处理中的Transformer模型真正改变了我们处理文本数据的方式。Transformer是最近自然语言处理发展的幕后推手,包括Google的BERT。了解Transformer的工作原理、它如何与语言建模、序列到序列建模相关,以及它如何支持Google的BERT模型 【超详细】【原理篇实战篇】一文读懂TransformerCSDN博客2019年3月6日 — 噪声增益相对于Multiple Feedback拓扑(反向效果,噪声增益加一)来说,小了1。 当 增益要求增大 时,Sallenkey滤波器的噪声增益取决于采用的阻容器件的精度,此时,仍然要比Multiple Feedback结构小了一个单位,但随着增益加大,这种噪声增益小 滤波器拓扑结构:Sallenkey和Multiple Feedback CSDN博客

.jpg)

Multitask Learning 理论 (多任务学习) 晓柒NLP 博客园

2022年11月11日 — Multigate MoE model:底层特征共享方式的一大特点是在任务之间都比较相似或者相关性比较大的场景下能带来很好的效果,归纳偏置的作用也能够很好的发挥出来,而对于任务间差异比较大的场景,这种共享结构就有点捉襟见肘了。2024年4月29日 — 文章浏览阅读72k次,点赞49次,收藏53次。本文详细阐述了多头注意力机制在深度学习中的原理、实现,以及其在NLP和CV中的应用。介绍了其优点(增强表达、学习效率、多样性)和缺点(计算成本、解释性、过拟合),并探讨了其与CNN、RNN的 深度探索:机器学习中的多头注意力机制(MultiHead 2023年11月30日 — 图1:Informer模型结构[1]如果对图1还不太熟悉的同学,可以参考图2。由图2可知,informer与Transformer之间的差异并不大。主要区别是ProbAttention和可能的encoder最后一层的conv(源代码中用 AAAI最佳论文Informer 解读 CSDN博客2020年6月16日 — 在本文中,马尔文仪器将向您介绍MALS检测仪的工作原理,总结它们在特定应用中的优势,并重点介绍那些决定其性能的特点。本文可以作为帮助用户判断MALS在何种情况下最为适用的指南,并帮助那 多角度光散射(MALS)检测器工作原理及性能特点

.jpg)

SFM(structure from motion 从运动恢复结构)和MVS(multi

2023年6月6日 — 简单说明 SFM是Structrue From Motion(从运动恢复结构)。MVS是Multi View Stereo(多视图立体),SFM生成的是稀疏点云,恢复相机之间的几何关系,MVS生成的是密集点云。由sfm获得的一些相机参数和相机之间的几何关系,而MVS是对上面步骤的细化从而产生所谓的密集重构。2021年8月12日 — GPT(Generative PreTrained Transformer,生成式预训练Transformer模型),它是基于Transformer的Decoder解码器在海量文本上训练得到的预训练模型。GPT采用自回归的工作方式,能够查看句子的一部分并且预测下一个单词,不断重复这个过程来生成连贯且适当上下文文本。GPT模型总结【模型结构及计算过程详细说明】 CSDN博客2020年1月20日 — 电流探头在测试直流和低频交流时的工作原理 : 当电流钳闭合,把一通有电流的导体围在中心时,相应地会出现一个磁场。这些磁场使霍尔传感器内的电子发生偏转,在霍尔传感器的输出产生一个电动势。电流探头根据这个电动势产生一个反向 深入理解示波器探头各种作用及工作原理 CSDN博客2022年1月16日 — PCIe设备可以使用MSI或者MSIX报文向处理器提交中断请求,但是对于某个具体的PCIe设备,可能仅支持一种报文。在PCIe设备中含有两个Capability结构,一个是MSI Capability结构,另一个是MSIX Capability结构。通常情况下一个PCIe设备仅包含一种结构,或者为MSI Capability结构,或者为MSIX Capability结构。PCIe中MSI和MSIX中断机制详解 CSDN博客

.jpg)

【Transformer 模型结构原理超级详细解析】 CSDN博客

2022年1月30日 — Transformer 模型的核心思想是利用自注意力机制来建模序列中的依赖关系,从而实现并行计算,并且通过堆叠多层自注意力层和前馈神经网络层来实现更深层次的语义建模。自注意力机制(SelfAttention):自注意力机制是 Transformer 模型的关键组成部分,它允许模型在处理序列数据时,能够根据序列中 2023年4月17日 — 在本文中我们重点介绍Transformer中的掩码机制及多头自注意力模块的原理以及代码实现。掩码机制是Transformer中非常重要的一个部分,在模型结构图中的三个地方有用到掩码机制,如下图所示。Transformer中的掩码分为两种,分别是填充mask和因 MultiHeadAttention多头注意力机制的原理多头自注意力 2019年3月7日 — 多示例学习(multipleinstance learning)是1997年被提出的。 其与监督学习、半监督学习和非监督学习有所不同,它是以多示例包(bag)为训练单元的学习问题。 在多示例学习中,训练集由一组具有分类标签的多示例包(bag)组成,每个多包(bag)含有若干个没有分类标签的示例(instance)。多示例学习(Multiple Instance Learning) CSDN博客2022年3月4日 — 【图文详解】超级结MOSFET结构、工作原理KIA MOS 管 超级结MOSFET(SJMOS) (1)SJMOS在N层具有柱状P层(P柱层)。P层和N层交替排列。(参见图39(b)) (2)通过施加VDS,耗尽层在N层中扩展,但其在SJMOS中的扩展方式与在一般D 【图文详解】超级结MOSFET结构、工作原理KIA MOS管

.jpg)

MIMO及大规模MIMO的技术原理与应用 CSDN博客

2023年9月12日 — 1MIMO的技术原理 MIMO,即多入多出(MultipleInput MultipleOutput),是指在无线通信系统的发射端和接收端同时使用多个天线的通信技术。 如图1所示。 图1 MIMO系统 MIMO技术最早由无线通信技 2021年6月16日 — 一、前提概要什么是MVCC?MVCC,全称MultiVersion Concurrency Control,即多版本并发控制。MVCC是一种并发控制的方法,一般在数据库管理系统中,实现对数据库的并发访问,在编程语言中 MVCC多版本并发控制原理总结(最终版) 郭慕荣2024年1月17日 — 随着5G时代的到来,TDMA技术将继续发挥重要作用,并与其他多址技术相结合,推动通信技术的创新和进步。 # 2 时间分割多址通信原理 ## TDMA原理图示 **TDM:按时间将信道划分为N个时隙,并行传输N路数据。时分多址(TDMA)技术:时间分割多址通信原理与应用 2022年8月1日 — 激光与原子能、计算机、半导体被并称为20世纪人类的四大发明。上次对比了激光雷达和其他传感器的优缺点,分析了激光雷达爆火的原因。这次来聊一下激光的原理。激光的发明要追溯到爱因斯坦。爱因斯坦最先提出了光的“波粒二象性”概念,借此对黑体辐射的普兰克定律进行了重新推导。一文彻底搞懂激光雷达原理! CSDN博客

2024年大模型Multiagent多智能体应用技术:AutoGen

2024年1月16日 — AutoGen应该说是2023年最成功的MultiAgent的Framework之一,为了减少开发人员跨各个域创建复杂LLM应用程序所需的工作量,AutoGen的一个核心设计原则是精简和使用多智能体对话来整合多智能体工作流。2023年3月1日 — 02多级泵的工作原理 被输送的液体,在给定的压力下进入泵的吸入口,由于叶轮的作用,使液体的动能和势能都增加,液体进入导叶后,一部分动能转换为势能(每一级叶轮都配有一个导叶),导叶的反叶片在有利的水力特性下把液体输送到下一级叶轮的入口。多级泵的结构与工作原理 知乎2023年9月25日 — 本文为“一步步手撸Transformer”系列的第二篇,重点讲解了“多头注意力(MultiHead Attention)”机制。多头注意力是自注意力(SelfAttention)的一个扩展,首次在2017年由Vaswani等人在"Attention Is All You Need"论文中提出。在Transformer模型中,注意力机制主要在三个地方使用:编码器的自注意力、解码器的自 一步步手撸Transformer之(二)—— Multihead Attention 2024年8月11日 — multiple definition of 问题解决方法 在编写代码时,我想让两个接口的函数从公用一个,现在分为两个来使用,但是函数的名字相同,放在两个不同的C文件中, 编译后发现,在链接的时候,出现如下错误: multiple definition of `函数名' 分析是因为两个函数重 multiple definition of `xxxx`问题解决及其原理 CSDN博客

单片机原理——MCS51单片机结构及原理mcs51单片机

2022年6月7日 — 单片机概述发展概况单片机主要技术指标MSC51系列芯片主要性能MCS51单片机的结构与原理8051单片机主要功能图共性(最好记住)MCS51硬件系统结构CPU内部结构1算术逻辑运算单元ALU(8位)2寄存器阵列8051存储器结构程序存储器数据 2018年10月16日 — 本篇随笔为转载,原文知乎,深度学习中Attention Mechanism详细介绍:原理、分类及应用。参考链接:深度学习中的注意力机制。Attention是一种用于提升基于RNN(LSTM或GRU)的Encoder + Decoder模型的效果的的机制(Mechanism),一般称为Attention Mechanism。 深度学习中Attention Mechanism详细介绍:原理、分类及 2024年3月25日 — 专注探讨UUID的核心原理及其生成机制,并详细介绍不同版本UUID(如版本1的时间戳+节点ID、版本4的随机数生成等)背后的数学原理和技术细节。 uuid 深度解读UUID:结构、原理以及生成机制深度解读UUID:结构、原理以及生成机制 CSDN博客2024年1月13日 — 文章浏览阅读23w次,点赞84次,收藏211次。一文搞懂MOSFET结构、符号、工作原理mosfet电路符号 文章目录0 什么是三极管1 双极性晶体管(BJT)2 场效应晶体管(FET)21结型场效应 一文搞懂MOSFET结构、符号、工作原理(一)

雷克萨斯多级混动系统(L110L310) 知乎专栏

2019年2月10日 — 到2018年,在LC500H车型上,雷克萨斯将其两级混动系统进一步升级为多级混动系统(MultiStage Hybrid System),就是带四级减速器的ECVT L310 。下表为雷克萨斯的混动系统进化过程的代表车型: L110/L110F结构与原理 L110为两级速混动变速 2023年11月24日 — 在前几篇文章中,我们已经了解了什么是Transformer,它的架构以及它的工作原理。 在本文中,我们将更进一步深入探讨多头注意力(Multihead Attention),这也是Transformer的核心。 Transformer中注意力机制的使图解Transformer之三:深入理解MultiHead Attention 知乎2023年7月4日 — 将ARM处理器作为NoC系统中的一个资源节点,设计了资源网路接口,基于Linux操作系统的基础上,编写了FPGA设备的驱动程序。在典型的3×3 2D Mesh结构的NoC系统中进行了测试,结果表明该设计实现了ARM处理器资源节点和NoC系统中其他IP核数据的高速、可靠传输。基于NoC的多处理器系统; NoC的基本结构和原理;Router 2024年7月9日 — MultiHead Attention网络结构解析 Transformer采用多头注意力机制,模型网络结构如下 MultiHead Attention 其中h表示头的个数,每个头都包含单独的一个缩放点积注意力以及注意力前的线性映射层,多个头的结果concat,输入到最后的全连接映射层,缩放点积Transformer系列:MultiHead Attention网络结构和代码解析

multimap的相关原理——(映照容器)

2020年2月3日 — multimap的介绍及使用 1、multimap的介绍 1、multimap是关联式容器,它按特定的次序(按照key来比较)存储由键key和值value组合而成的元素,多个键值对之间的key可以重复 2、在multimap中,键值key通常用于排序和唯一标识元素,值value中存储与键key关联的内容。2023年11月27日 — 文章浏览阅读940次。本文介绍了MultiLoRA,通过改善LoRA奇异值分解不均匀的问题,提高LoRA在多任务领域的性能表现。本文通过多个LoRA连加并且引入可训练的系数因子改变LoRA中B矩阵的初始化方式提高性能表现。通过多个空间特征的热力图 【论文阅读笔记】MultiLoRA: Democratizing LoRA For 2024年2月2日 — 熔断器串联应用在被保护电路中时,其基本工作原理可简述如下:当电路工作电流小于或等于其额定正常负载电流时,熔断器内熔体的温度较低,熔体保持在固体状态;当被保护电路发生过载或短路时,电流会超过正常值,熔体温度会逐步提高。一文读懂:熔断器的基本结构、工作原理及物理过程 知乎